Ultimate Guide to Ethical AI Personalization

Concilier personnalisation et vie privée : principes, risques et bonnes pratiques pour une IA transparente, conforme au RGPD, équitable et auditée.

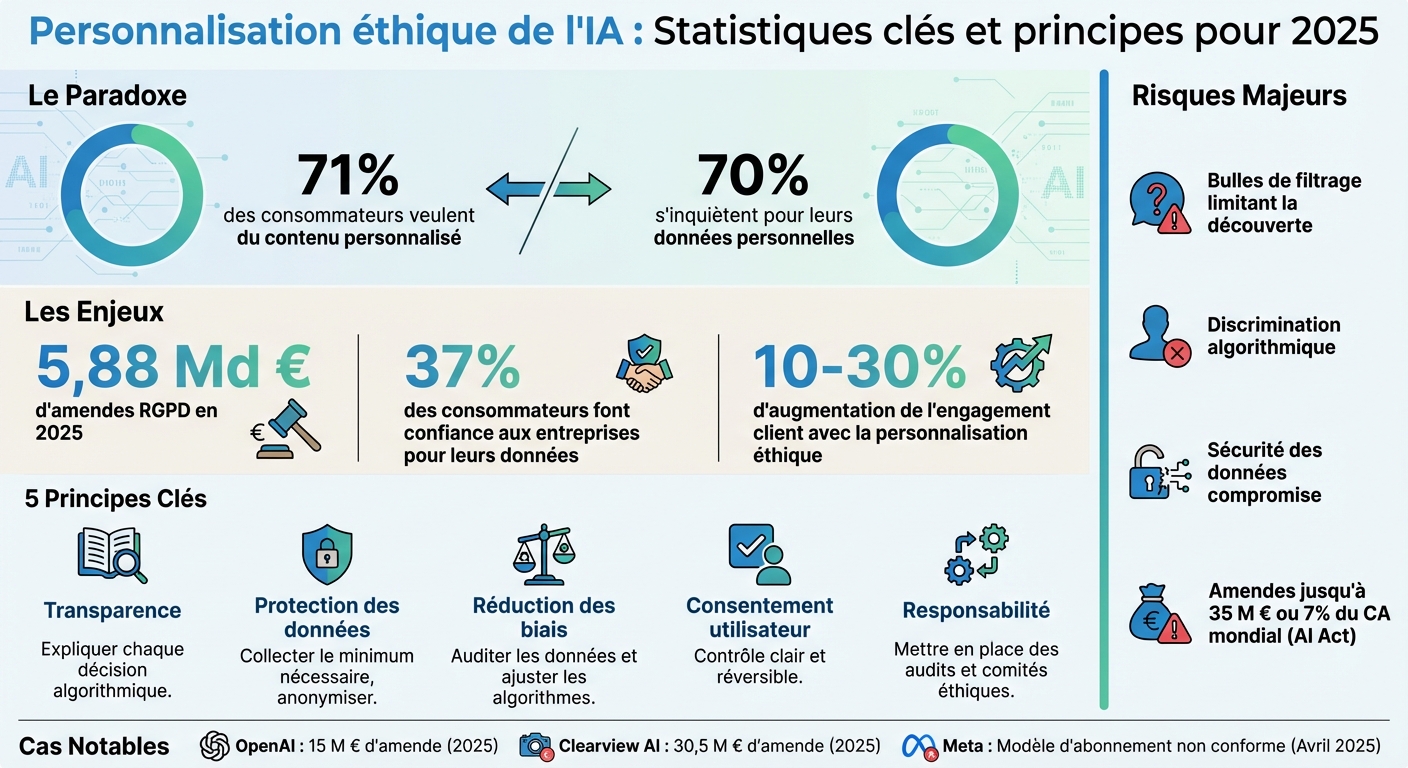

71 % des consommateurs veulent du contenu personnalisé, mais 70 % s’inquiètent pour leurs données personnelles. Ce paradoxe pousse les marques à trouver un équilibre entre personnalisation et respect de la vie privée. L'IA éthique offre une solution : ajuster les expériences utilisateur tout en garantissant transparence, sécurité et conformité réglementaire. En 2025, les amendes RGPD ont atteint 5,88 milliards d’euros, confirmant l’importance croissante de ces enjeux.

Principes clés pour une IA éthique :

- Transparence : Expliquez chaque décision algorithmique (ex. : IA explicable).

- Protection des données : Collectez le minimum nécessaire et anonymisez.

- Réduction des biais : Auditez vos données et ajustez vos algorithmes.

- Consentement utilisateur : Assurez un contrôle clair et réversible.

- Responsabilité : Mettez en place des audits et comités éthiques.

Risques d’une IA non éthique :

- Bulles de filtres limitant les découvertes.

- Discrimination algorithmique (ex. : prix basés sur des données biaisées).

- Sécurité des données compromise.

Solutions pratiques :

- Auditez vos systèmes pour détecter les biais.

- Proposez des options de consentement détaillées.

- Utilisez des outils comme IBM AI Fairness 360 pour surveiller l’équité des algorithmes.

Exemple : Feedcast.ai aide les marques à personnaliser sans profilage intrusif, en mettant l’accent sur les produits, pas les utilisateurs. Avec des options à partir de 0 €/mois, elle garantit conformité RGPD et transparence.

Conclusion : La confiance est la clé. Une personnalisation responsable booste l’engagement client de 10 à 30 %, tout en évitant des sanctions coûteuses. Les marques doivent agir maintenant pour allier performance et respect des utilisateurs.

::: @figure  {Ethical AI Personalization: Key Statistics and Principles for 2025}

{Ethical AI Personalization: Key Statistics and Principles for 2025}

IA éthique et responsable : Comment passer à l'échelle

Principes éthiques fondamentaux pour la personnalisation par IA

Pour instaurer une personnalisation par IA qui inspire confiance, cinq principes clés doivent orienter chaque décision stratégique. Ces piliers permettent de conjuguer performance commerciale, respect des utilisateurs et conformité aux réglementations en vigueur. Explorons chacun de ces principes.

Transparence dans les décisions de l'IA

La transparence repose sur une règle simple : expliquer pourquoi chaque décision algorithmique est prise. Par exemple, un bouton « Pourquoi ? » placé à côté d'un contenu personnalisé pourrait fournir une explication claire, comme : « Nous vous recommandons ces baskets de running car vous avez consulté cette catégorie trois fois ce mois-ci »[3].

Megan Yu, Product Manager chez Salesforce Interaction Studio, résume parfaitement cette idée :

The more transparent you are about your personalization strategy, the easier it is for customers to understand what data they should provide based on how it will be used. [2]

Les tableaux de bord de transparence vont encore plus loin. Ils offrent aux utilisateurs un portail visuel « Mes données & personnalisation », où ils peuvent voir précisément ce que l'IA connaît d'eux et comment ces informations influencent leur expérience. En décembre 2020, Grubhub a appliqué ce principe dans sa campagne « Taste of 2020 », utilisant 32 attributs personnalisés par utilisateur. Résultat : une hausse de 100 % des mentions sur les réseaux sociaux et une augmentation de 18 % des recommandations par bouche-à-oreille[4].

Sur le plan technique, l'IA explicable (XAI) est essentielle pour documenter chaque modèle et permettre d’auditer ou d’expliquer ses décisions aux utilisateurs ou aux régulateurs[1]. Cette démarche s'aligne également sur l'article 22 du RGPD, qui garantit un droit à l'explication pour toute décision automatisée ayant un impact significatif[3].

Protection des données et conformité RGPD

La conformité au RGPD repose sur le principe de « protection dès la conception », qui consiste à intégrer la sécurité des données dès les premières étapes de développement[1]. Cela inclut la collecte des données strictement nécessaires, conformément au principe de minimisation[3].

Les demandes de données « juste-à-temps » illustrent bien cette approche. Par exemple, ne demander la géolocalisation que lorsque l'utilisateur cherche un magasin à proximité[3]. De plus, remplacer les bannières génériques « Tout accepter » par des options granulaires, comme « Essentiel uniquement » ou « Personnalisation complète », renforce l’autonomie des utilisateurs tout en maintenant une expérience de qualité.

L'anonymisation des données a permis d'améliorer la précision de la personnalisation de 30 % tout en respectant les réglementations[1]. Par ailleurs, les évaluations d’impact sur la protection des données (DPIA) sont obligatoires pour les traitements IA à haut risque, car elles identifient les menaces potentielles pour les droits des individus[6]. En 2025, OpenAI a reçu une amende de 15 millions d'euros pour des manquements en matière de transparence et de vérification d'âge[1].

Détection et réduction des biais

Les biais algorithmiques proviennent souvent de données d'entraînement reflétant des préjugés ou un manque de diversité, ce qui peut fausser les résultats[1]. Pour y remédier, il est crucial de procéder à des audits réguliers des données avant le déploiement, en s'assurant qu'elles représentent bien toutes les populations et en identifiant les biais potentiels[1].

Des métriques comme les tests de parité démographique ou d'égalisation des chances aident à mesurer l'équité des algorithmes[1]. L'Information Commissioner's Office (ICO) définit ainsi l'équité :

Fairness means you should only process personal data in ways that people would reasonably expect and not use it in any way that could have unjustified adverse effects on them. [6]

Enfin, intégrer des contraintes d'équité directement dans les algorithmes peut garantir un traitement équitable entre différents groupes démographiques[1].

Consentement et contrôle des utilisateurs

Le consentement des utilisateurs doit être explicite, éclairé et réversible à tout moment. Les pratiques comme « payez pour la confidentialité », où les utilisateurs doivent payer pour éviter le suivi publicitaire, ont été jugées non conformes par la Commission européenne en 2025, car elles ne respectent pas les critères de consentement libre au sens du RGPD[3].

Pour garantir ce principe, il est conseillé de mettre en place des tableaux de bord permettant aux utilisateurs de gérer facilement leurs préférences. Par exemple, des interrupteurs simples pour désactiver certains types de profilage ou supprimer des données spécifiques[3]. Des messages contextuels, comme « Partagez votre historique d’achats pour des recommandations 40 % plus pertinentes », renforcent également la clarté du consentement[3]. Enfin, il est essentiel de définir des objectifs précis pour chaque usage des données et de s'assurer que toute nouvelle utilisation reste conforme au consentement initial[6].

Responsabilité dans les systèmes d'IA

La responsabilité exige que les organisations assument pleinement leurs décisions algorithmiques et corrigent rapidement toute dérive. Cela passe par une gouvernance interne rigoureuse, incluant la création de comités éthiques et des audits réguliers des systèmes d'IA, afin d'assurer transparence et conformité dans toutes les opérations.

Risques de la personnalisation par IA non éthique

Une personnalisation inadéquate via l'IA peut entraîner des conséquences graves pour les entreprises et leurs clients. À titre d'exemple, les amendes liées au RGPD ont atteint un total impressionnant de 5,88 milliards d'euros en 2025, avec une part croissante attribuée aux violations impliquant l'IA [1]. Malgré cela, seulement 37 % des consommateurs déclarent faire confiance aux entreprises pour la gestion de leurs données personnelles [1]. Passons en revue les dérives spécifiques que cette technologie peut engendrer.

Bulles de filtres et manipulation algorithmique

Une personnalisation mal pensée peut enfermer les utilisateurs dans des « bulles de filtres », limitant leur accès à une variété de contenus et produits. Ce phénomène crée un effet de chambre d'écho, réduisant la satisfaction des utilisateurs et freinant leur découverte de nouveaux articles. Par ailleurs, certaines IA exploitent des vulnérabilités psychologiques en recourant à des tactiques comme le défilement continu ou des signaux de rareté artificiels [1].

Un exemple frappant est la discrimination tarifaire dynamique.

"J'ai assisté à des réunions où les équipes juridiques étaient horrifiées d'apprendre que l'outil IA du service marketing modifiait les prix en fonction de la richesse supposée des utilisateurs, déduite de leur historique de navigation. C'est le genre de bombe à retardement en matière de conformité que l'IA a plantée dans des milliers d'organisations." – Ansari Alfaiz, Directeur Marketing Digital et Expert en Conformité RGPD [3]

Cette pratique peut être considérée comme une prise de décision automatisée discriminatoire au sens de l'article 22 du RGPD. En octobre 2025, Meta a fait polémique en utilisant les discussions de ses chatbots IA pour cibler des publicités. Par exemple, un utilisateur mentionnant des spots de randonnée voyait immédiatement des publicités pour des chaussures de randonnée sur Instagram [3].

Vulnérabilités en matière de sécurité des données

Au-delà des bulles de filtres, ces pratiques soulèvent également des préoccupations majeures en matière de sécurité. Les systèmes d'IA peuvent déduire des informations sensibles (comme l'état de santé ou le niveau de revenus) sans que ces données soient explicitement fournies, ce qui constitue une atteinte à la vie privée. De plus, des techniques avancées permettent de réidentifier des individus à partir de données anonymisées, rendant inefficaces les méthodes d'anonymisation classiques. En 2025, Clearview AI a écopé d'une amende de 30,5 millions d'euros pour des violations liées à la reconnaissance faciale et à des protections insuffisantes [1].

"Si votre stratégie de personnalisation est mal gérée ou fragmentée, les coûts pour la corriger seront élevés – à la fois en termes d'investissements directs et des dégâts causés à votre réputation par des données non sécurisées ou un marketing intrusif." – Megan Yu, Responsable Produit Interaction Studio, Salesforce [2]

Résultats discriminatoires issus de données biaisées

Les IA s'appuient souvent sur des données historiques qui peuvent refléter des biais existants, entraînant des expériences différentes – et parfois inférieures – pour certains groupes démographiques [1]. Par exemple, cibler uniquement les personnes âgées pour des produits anti-âge renforce les stéréotypes et peut aliéner d'autres groupes de consommateurs potentiels [2]. Ces pratiques peuvent nuire durablement à la réputation de la marque. En vertu de l'AI Act européen, les infractions liées aux systèmes d'IA à haut risque peuvent entraîner des amendes allant jusqu'à 35 millions d'euros ou 7 % du chiffre d'affaires mondial [1]. En avril 2025, la Commission européenne a jugé que l'offre d'abonnement « sans publicité » de Meta ne respectait pas les exigences du RGPD, car elle obligeait les utilisateurs à renoncer à leurs droits à la vie privée [3].

| Tactique de personnalisation IA | Niveau de risque | Principal risque de conformité |

|---|---|---|

| Ciblage comportemental prédictif | ÉLEVÉ | RGPD Art. 22, Absence de consentement |

| Adaptation tarifaire en temps réel | CRITIQUE | RGPD Art. 22, Discrimination |

| Analyse de sentiment par chatbot | ÉLEVÉ | Absence de consentement pour le profilage |

| Personnalisation par cohortes | FAIBLE | Données minimales, généralement sûr |

Ces exemples mettent en lumière l'importance d'adopter des pratiques responsables en matière d'IA, non seulement pour protéger les individus, mais aussi pour préserver la réputation des entreprises.

Comment mettre en œuvre une personnalisation par IA éthique

Une fois les risques identifiés, il est temps de passer à l'étape pratique. Assurer une personnalisation éthique avec l'IA repose sur trois axes majeurs : auditer les données, établir des directives internes claires et maintenir un contrôle continu des systèmes. Ces mesures ne se limitent pas à la conformité réglementaire ; elles renforcent aussi la confiance des clients en garantissant une transparence totale sur l'utilisation des données. Voici comment mettre en place ces pratiques essentielles.

Audit des données d'entraînement pour garantir l'équité

L'audit des données est une étape cruciale. La performance de votre IA est directement liée à la qualité et à la représentativité des données utilisées pour son entraînement. Assurez-vous que ces données reflètent la diversité de vos utilisateurs. Cela implique d’examiner vos jeux de données pour repérer et corriger tout biais éventuel [1]. Avant de commencer l'entraînement, appliquez des techniques de prétraitement et d'anonymisation pour limiter les biais [1]. Adoptez également une approche de minimisation des données : collectez uniquement ce qui est nécessaire, ce qui réduit les risques et simplifie la conformité au RGPD [8].

Établissement de directives éthiques internes

Pour garantir une personnalisation éthique, une gouvernance interne solide est indispensable. Cela commence par la création d’un comité éthique regroupant des experts techniques et juridiques [8]. Intégrez dès le départ le principe de « Privacy-by-Design » dans la conception de vos systèmes [8]. Préférez un ciblage basé sur les centres d’intérêt plutôt que sur des critères démographiques, afin d’éviter de renforcer les stéréotypes [2]. Élaborez des objectifs clairs alignés sur le ROI et des lignes directrices qui guideront vos algorithmes [9]. Mettez en place des protocoles d’explicabilité (XAI) pour que vos recommandations soient compréhensibles [7]. Enfin, proposez des options de consentement nuancées – par exemple, des niveaux comme « Essentiel uniquement », « Fonctionnel et Analytique » ou « Personnalisation complète et Publicités » – plutôt qu’un simple bouton « Tout accepter » [3].

Réalisation d'audits réguliers des systèmes d'IA

La surveillance continue est essentielle pour maintenir l'équité de vos systèmes d'IA. Effectuez régulièrement des audits pour identifier et corriger les biais [7]. Mesurez les biais à l’aide de métriques quantitatives comme la parité démographique, l’égalité des chances et l’équité individuelle [7]. Surveillez également l’apparition de nouveaux biais au fil du temps [1]. Une supervision humaine doit être prévue pour gérer les cas complexes ou sensibles [7]. Pour les systèmes présentant des risques élevés pour la vie privée, réalisez des Analyses d’Impact relatives à la Protection des Données (AIPD) [1]. Enfin, les systèmes d’IA à haut risque, tels que définis par l’AI Act européen, nécessitent des évaluations de conformité rigoureuses, un système de gestion des risques et une supervision humaine [1].

| Focus de l'audit | Personnalisation traditionnelle | Personnalisation par IA |

|---|---|---|

| Portée des données | Listes statiques, comportement passé | Flux en temps réel, intention prédictive [4] |

| Évaluation des risques | Erreurs de segmentation manuelle | Biais algorithmique, opacité [1] |

| Conformité | Consentement cookie standard | RGPD Art. 22 (Décision automatisée) [3] |

| Surveillance | Révisions périodiques de campagnes | Détection continue de dérive des biais [1] |

Mesurer la performance éthique de l'IA

Une fois les principes établis et les risques identifiés, il est tout aussi essentiel d’évaluer l’impact des pratiques éthiques mises en place. Adopter des mesures éthiques ne suffit pas : leur efficacité doit être mesurée à l’aide de KPI, d’outils de détection des biais et des retours clients. Voici un aperçu des indicateurs, outils et mécanismes de retour qui permettent de maintenir une éthique opérationnelle.

KPI pour l'équité algorithmique et la protection des données

Les indicateurs éthiques peuvent être regroupés en trois grandes catégories : l’équité algorithmique, la protection des données et la confiance des utilisateurs. Pour évaluer l’équité algorithmique, surveillez des métriques comme :

- La parité démographique : assurer un taux égal de prédictions positives entre différents groupes.

- L’égalité des chances : garantir des taux similaires de vrais positifs et de faux positifs.

- L’équité individuelle : traiter de manière cohérente des profils présentant des caractéristiques similaires [1].

En matière de protection des données, des indicateurs comme les taux de consentement utilisateur, le respect des délais de conservation des données et la fréquence des incidents de sécurité sont essentiels [1]. Enfin, la qualité des explications fournies par l’IA, le niveau de compréhension des utilisateurs et leur confiance dans le système doivent également être mesurés.

La confiance des utilisateurs, en particulier, joue un rôle clé. Elle influence directement la fidélité et la valeur vie client (LTV). Même si des politiques plus strictes, comme des opt-ins renforcés, peuvent temporairement réduire les taux de conversion, elles conduisent souvent à des relations client plus solides sur le long terme [3].

Outils pour détecter et atténuer les biais

Outre les KPI, des outils spécialisés permettent d’identifier et de corriger les biais dans les systèmes d’IA. Parmi eux :

- IBM AI Fairness 360 : une bibliothèque open-source offrant plus de 70 métriques d’équité pour détecter et corriger les biais à différentes étapes du cycle de vie de l’IA [1].

- Aequitas : génère des rapports d’audit détaillés pour les décideurs et les chercheurs.

- Fairlearn : propose des algorithmes conçus pour réduire les traitements discriminatoires entre groupes démographiques [1].

Ces outils analysent notamment les faux positifs et faux négatifs par groupe démographique [11]. Une approche technique efficace est le debiasing adversarial, qui entraîne les modèles à produire des prédictions précises tout en les rendant incapables de deviner des attributs protégés comme le genre ou l’origine ethnique [1].

Boucles de feedback client pour améliorer l’éthique

Les retours clients sont souvent une mine d’informations pour détecter des problèmes éthiques que les métriques internes ne captent pas. Par exemple, l’analyse de sentiment appliquée à toutes les interactions clients (appels, chats, avis) peut révéler des points de friction éthiques ou des tendances de satisfaction [12].

Un exemple concret : en 2024, Tapestry, maison-mère de Coach et Kate Spade, a introduit son IA « Tell Rexy » pour améliorer le service client. Ce système intègre une boucle de feedback où les représentants humains ajustent les réponses de l’IA pour qu’elles restent alignées avec les valeurs de la marque [10].

Pour aller plus loin, mettez en place des canaux de signalement directs où clients et employés peuvent remonter des préoccupations éthiques ou des biais observés. Une approche efficace consiste également à utiliser des divulgations par étapes. Plutôt que de longues politiques de confidentialité, proposez des pop-ups contextuels qui expliquent, au moment opportun, comment les données sont utilisées et invitent à donner un retour immédiat [12]. Cette démarche dépasse la simple conformité réglementaire et renforce la relation de confiance avec les clients [12].

Utiliser Feedcast.ai pour une personnalisation IA éthique

Examinons comment Feedcast.ai aide les e-commerçants à intégrer des pratiques éthiques dans leurs campagnes publicitaires. Adoptée par plus de 3 000 marques, cette plateforme propose des outils de personnalisation qui respectent la vie privée tout en maximisant l’efficacité publicitaire. Voici un aperçu des fonctionnalités qui illustrent cette approche.

Fonctionnalités d'IA pour une publicité responsable

Avec Feedcast.ai, l’accent est mis sur le catalogue produit, évitant ainsi tout profilage intrusif. Grâce à son AI Studio, la plateforme enrichit automatiquement les données produits (comme les titres, descriptions et attributs), permettant de créer des annonces plus pertinentes, sans avoir besoin de collecter des données sensibles sur les utilisateurs [5]. Par exemple, jusqu’à 1 247 produits peuvent être synchronisés pour générer des publicités personnalisées, basées uniquement sur les caractéristiques des articles.

De plus, l’optimisation des enchères et du ciblage repose sur des indicateurs objectifs, tels que le ROAS et le CPC. Cela évite les biais ou pratiques discriminatoires, comme des variations de prix injustifiées [5][3]. En s’appuyant sur des critères mesurables et transparents, Feedcast.ai garantit une utilisation responsable et efficace de l’intelligence artificielle.

Conformité et transparence pour les campagnes e-commerce

Feedcast.ai est partenaire certifié CSS Google, ce qui l’engage à respecter des normes strictes en matière de confidentialité et de gestion des données [5]. Cette certification assure une conformité avec le RGPD, renforçant la protection des données des utilisateurs. La plateforme offre également un tableau de bord unifié, regroupant les données de Google, Meta et Microsoft. Cela permet aux entreprises de suivre précisément leurs dépenses publicitaires et le ciblage effectué par l’IA [5].

En outre, Feedcast.ai adopte des politiques claires sur l’utilisation des données, renforçant ainsi la confiance des utilisateurs. Une enquête révèle d’ailleurs que 92 % des consommateurs préfèrent les marques qui expliquent clairement comment leurs données sont utilisées [2].

Une approche équitable du ciblage publicitaire

Feedcast.ai favorise un ciblage basé sur les centres d’intérêt, évitant ainsi les biais liés aux données démographiques [2]. Cette méthode associe les produits aux acheteurs potentiels sans se baser sur des critères comme l’âge, le genre ou l’origine, en accord avec les principes d’équité algorithmique mentionnés dans la première partie du guide.

La plateforme garantit également une mise à jour précise des données produits sur tous les canaux, prévenant ainsi toute publicité trompeuse. Les e-commerçants peuvent auditer régulièrement les campagnes pour s'assurer qu’elles respectent des pratiques de ciblage équitables [5][3].

Feedcast.ai propose plusieurs plans tarifaires adaptés aux besoins variés des entreprises :

- Starter gratuit : produits illimités, validation produit, 5 crédits IA.

- Autopilot à 99 €/mois : 1 canal publicitaire, 150 crédits IA.

- Premium à 249 €/mois : canaux publicitaires illimités, 500 crédits IA [5].

Cette structure tarifaire permet aux entreprises, quelles que soient leur taille ou leurs ressources, d’accéder à une personnalisation éthique sans barrière financière.

Conclusion

En 2026, la confiance est devenue l'atout le plus précieux pour une marque e-commerce, surpassant même l'importance des volumes de données collectées. Cette évolution impose une transformation majeure dans la manière dont les entreprises abordent la personnalisation via l'IA. Les consommateurs réclament désormais une transparence totale et une approche éthique dans l'utilisation de leurs données, tout en recherchant des expériences sur mesure.

Les entreprises qui s'engagent dès aujourd'hui dans des pratiques responsables se positionnent pour un avantage durable. Miser sur l'éthique ne se limite pas à éviter des amendes ou des régulations contraignantes, cela protège aussi la réputation de la marque sur le long terme. À l'inverse, les abus ou violations liés à l'IA peuvent engendrer des sanctions sévères et des dégâts d'image difficiles à surmonter.

Heureusement, des solutions concrètes existent pour allier efficacité publicitaire et responsabilité. Par exemple, des outils comme Feedcast.ai montrent qu'il est possible de performer tout en respectant des principes éthiques. Plutôt que de s'appuyer sur un profilage intrusif, cette plateforme privilégie l'amélioration des données produits et offre une transparence totale grâce à un tableau de bord unifié. Avec des offres débutant à 0 €/mois, elle rend la personnalisation éthique accessible à toutes les entreprises, quelle que soit leur taille.

L'avenir du e-commerce appartiendra aux marques qui intègrent la transparence, l'équité et le contrôle utilisateur au cœur de leur stratégie. Les chiffres parlent d'eux-mêmes : une personnalisation éthique peut augmenter l'engagement client de 10 à 30 %[1], prouvant que responsabilité et rentabilité peuvent parfaitement coexister.

FAQs

Comment l’utilisation de l’IA éthique peut-elle renforcer la confiance des consommateurs dans la personnalisation ?

L’intelligence artificielle peut transformer l’expérience client en la rendant plus personnalisée, mais cela ne doit jamais se faire au détriment de la vie privée ou de la transparence. En respectant ces principes, les marques peuvent utiliser la personnalisation comme un outil pour bâtir une relation de confiance, où les consommateurs se sentent protégés et en contrôle de leurs données.

Pour atteindre cet équilibre, plusieurs pratiques sont indispensables :

- Obtenir un consentement explicite : Les consommateurs doivent avoir des options claires pour gérer leurs préférences.

- Limiter la collecte de données : Se concentrer uniquement sur les informations strictement nécessaires, conformément au principe de minimisation.

- Expliquer les recommandations : Communiquer de manière simple et transparente sur les choix proposés.

- Éliminer les biais : Identifier et corriger les biais dans les algorithmes pour garantir une équité dans l’expérience utilisateur.

Des outils comme Feedcast.ai illustrent bien cette approche. En centralisant les données produits et en intégrant des solutions de gestion du consentement et de conformité réglementaire, Feedcast.ai permet aux e-commerçants de créer des publicités personnalisées tout en respectant la confidentialité des données. Résultat ? Les consommateurs se sentent en sécurité et sont plus enclins à partager leurs informations, créant ainsi un cercle vertueux entre personnalisation et fidélité.

Quelles sont les conséquences d'une personnalisation par IA non éthique dans le e-commerce ?

L'utilisation non éthique de l'intelligence artificielle pour personnaliser des services ou des produits peut engendrer des conséquences lourdes, tant pour les utilisateurs que pour les entreprises. Voici quelques exemples concrets :

Atteinte à la vie privée : Lorsque des données personnelles sont collectées de manière excessive ou sans consentement clair, cela peut non seulement violer la confidentialité des utilisateurs, mais aussi contrevenir à des réglementations strictes comme le RGPD. Ce type de pratique met en péril le droit fondamental des individus à contrôler leurs informations personnelles.

Biais et discriminations : Les algorithmes d'IA, s'ils sont formés sur des données biaisées, risquent de reproduire des stéréotypes ou d'exclure certaines catégories de personnes. Par exemple, un système de recommandation pourrait favoriser certains groupes au détriment d'autres, créant ainsi des inégalités dans l'accès aux services.

Manipulation des consommateurs : Certaines entreprises utilisent des techniques comme les dark patterns ou un ciblage publicitaire excessif pour influencer les décisions des utilisateurs. Ces pratiques peuvent inciter les consommateurs à effectuer des achats qu'ils n'auraient pas envisagés, érodant leur confiance envers la marque.

Pour les entreprises, ces dérives ne sont pas sans conséquences. Elles peuvent entraîner une perte de confiance de la part des clients, des litiges juridiques coûteux et une atteinte durable à leur réputation. En fin de compte, cela compromet non seulement les performances à court terme, mais aussi la pérennité de l’entreprise sur le long terme.

Comment Feedcast.ai assure-t-il une personnalisation respectueuse du RGPD ?

Feedcast.ai assure une personnalisation respectueuse du RGPD en utilisant exclusivement des données first-party recueillies directement auprès des boutiques en ligne, tout en tenant compte des préférences et du consentement explicite des utilisateurs. Aucune donnée provenant de sources tierces sans consentement n’est exploitée. La plateforme s’appuie sur des principes essentiels comme la minimisation des données, en ne conservant que les informations strictement nécessaires, et le droit à l’oubli, permettant aux commerçants de supprimer ou d’exporter les données des utilisateurs de manière simple et rapide.

Toutes les données sont hébergées sur des serveurs sécurisés situés dans l’Union européenne, avec des protocoles de chiffrement et des systèmes de protection avancés. L’intelligence artificielle de Feedcast.ai enrichit les fiches produits et génère des campagnes publicitaires uniquement après avoir obtenu un consentement explicite, garantissant ainsi une personnalisation respectueuse des règles locales de protection des données et des exigences éthiques.

Yohann B.