Guide ultime de la personnalisation éthique par l'IA

Concilier personnalisation et vie privée : principes, risques et bonnes pratiques pour une IA transparente, conforme au RGPD, équitable et auditée.

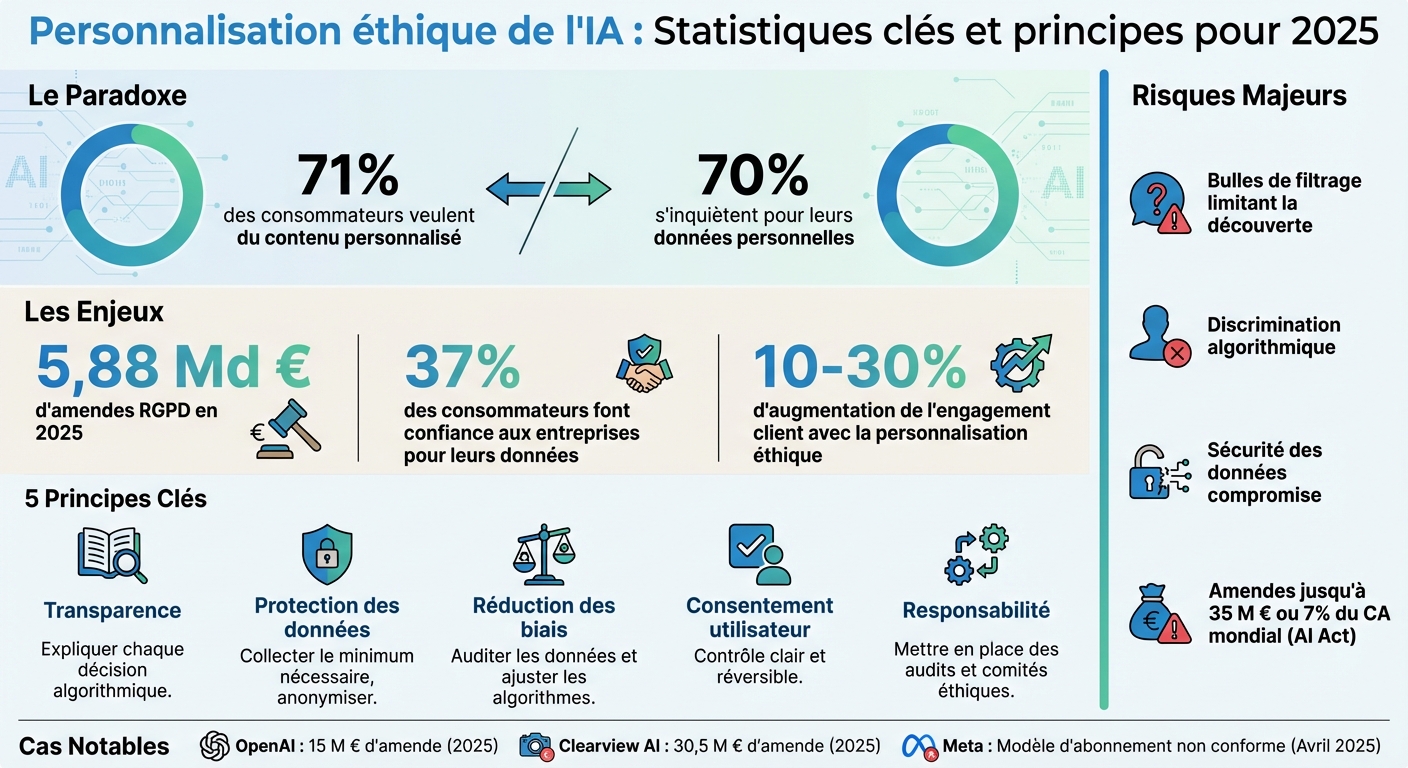

71 % des consommateurs veulent du contenu personnalisé, mais 70 % s’inquiètent pour leurs données personnelles. Ce paradoxe pousse les marques à trouver un équilibre entre personnalisation et respect de la vie privée. L'IA éthique offre une solution : ajuster les expériences utilisateur tout en garantissant transparence, sécurité et conformité réglementaire. En 2025, les amendes RGPD ont atteint 5,88 milliards d’euros, confirmant l’importance croissante de ces enjeux.

Principes clés pour une IA éthique :

- Transparence : Expliquez chaque décision algorithmique (ex. : IA explicable).

- Protection des données : Collectez le minimum nécessaire et anonymisez.

- Réduction des biais : Auditez vos données et ajustez vos algorithmes.

- Consentement utilisateur : Assurez un contrôle clair et réversible.

- Responsabilité : Mettez en place des audits et comités éthiques.

Risques d’une IA non éthique :

- Bulles de filtres limitant les découvertes.

- Discrimination algorithmique (ex. : prix basés sur des données biaisées).

- Sécurité des données compromise.

Solutions pratiques :

- Auditez vos systèmes pour détecter les biais.

- Proposez des options de consentement détaillées.

- Utilisez des outils comme IBM AI Fairness 360 pour surveiller l’équité des algorithmes.

Exemple : Feedcast.ai aide les marques à personnaliser sans profilage intrusif, en mettant l’accent sur les produits, pas les utilisateurs. Avec des options à partir de 0 €/mois, elle garantit conformité RGPD et transparence.

Conclusion : La confiance est la clé. Une personnalisation responsable booste l’engagement client de 10 à 30 %, tout en évitant des sanctions coûteuses. Les marques doivent agir maintenant pour allier performance et respect des utilisateurs.

::: @figure  {Personnalisation Éthique par IA : Statistiques Clés et Principes pour 2025}

{Personnalisation Éthique par IA : Statistiques Clés et Principes pour 2025}

IA éthique et responsable : Comment passer à l'échelle

Principes éthiques fondamentaux pour la personnalisation par IA

Pour instaurer une personnalisation par IA qui inspire confiance, cinq principes clés doivent orienter chaque décision stratégique. Ces piliers permettent de conjuguer performance commerciale, respect des utilisateurs et conformité aux réglementations en vigueur. Explorons chacun de ces principes.

Transparence dans les décisions de l'IA

La transparence repose sur une règle simple : expliquer pourquoi chaque décision algorithmique est prise. Par exemple, un bouton « Pourquoi ? » placé à côté d'un contenu personnalisé pourrait fournir une explication claire, comme : « Nous vous recommandons ces baskets de running car vous avez consulté cette catégorie trois fois ce mois-ci »[3].

Megan Yu, Product Manager chez Salesforce Interaction Studio, résume parfaitement cette idée :

Plus vous êtes transparent sur votre stratégie de personnalisation, plus il est facile pour les clients de comprendre quelles données ils doivent fournir en fonction de la manière dont elles seront utilisées. [2]

Les tableaux de bord de transparence vont encore plus loin. Ils offrent aux utilisateurs un portail visuel « Mes données & personnalisation », où ils peuvent voir précisément ce que l'IA connaît d'eux et comment ces informations influencent leur expérience. En décembre 2020, Grubhub a appliqué ce principe dans sa campagne « Taste of 2020 », utilisant 32 attributs personnalisés par utilisateur. Résultat : une hausse de 100 % des mentions sur les réseaux sociaux et une augmentation de 18 % des recommandations par bouche-à-oreille[4].

Sur le plan technique, l'IA explicable (XAI) est essentielle pour documenter chaque modèle et permettre d’auditer ou d’expliquer ses décisions aux utilisateurs ou aux régulateurs[1]. Cette démarche s'aligne également sur l'article 22 du RGPD, qui garantit un droit à l'explication pour toute décision automatisée ayant un impact significatif[3].

Protection des données et conformité RGPD

La conformité au RGPD repose sur le principe de « protection dès la conception », qui consiste à intégrer la sécurité des données dès les premières étapes de développement[1]. Cela inclut la collecte des données strictement nécessaires, conformément au principe de minimisation[3].

Les demandes de données « juste-à-temps » illustrent bien cette approche. Par exemple, ne demander la géolocalisation que lorsque l'utilisateur cherche un magasin à proximité[3]. De plus, remplacer les bannières génériques « Tout accepter » par des options granulaires, comme « Essentiel uniquement » ou « Personnalisation complète », renforce l’autonomie des utilisateurs tout en maintenant une expérience de qualité.

L'anonymisation des données a permis d'améliorer la précision de la personnalisation de 30 % tout en respectant les réglementations[1]. Par ailleurs, les évaluations d’impact sur la protection des données (DPIA) sont obligatoires pour les traitements IA à haut risque, car elles identifient les menaces potentielles pour les droits des individus[6]. En 2025, OpenAI a reçu une amende de 15 millions d'euros pour des manquements en matière de transparence et de vérification d'âge[1].

Détection et réduction des biais

Les biais algorithmiques proviennent souvent de données d'entraînement reflétant des préjugés ou un manque de diversité, ce qui peut fausser les résultats[1]. Pour y remédier, il est crucial de procéder à des audits réguliers des données avant le déploiement, en s'assurant qu'elles représentent bien toutes les populations et en identifiant les biais potentiels[1].

Des métriques comme les tests de parité démographique ou d'égalisation des chances aident à mesurer l'équité des algorithmes[1]. L'Information Commissioner's Office (ICO) définit ainsi l'équité :

L'équité signifie que vous ne devez traiter des données personnelles que de manière que les gens pourraient raisonnablement attendre et ne pas les utiliser d'une manière qui pourrait avoir des effets négatifs injustifiés sur eux. [6]

Enfin, intégrer des contraintes d'équité directement dans les algorithmes peut garantir un traitement équitable entre différents groupes démographiques[1].

Consentement et contrôle des utilisateurs

Le consentement des utilisateurs doit être explicite, éclairé et réversible à tout moment. Les pratiques comme « payez pour la confidentialité », où les utilisateurs doivent payer pour éviter le suivi publicitaire, ont été jugées non conformes par la Commission européenne en 2025, car elles ne respectent pas les critères de consentement libre au sens du RGPD[3].

Pour garantir ce principe, il est conseillé de mettre en place des tableaux de bord permettant aux utilisateurs de gérer facilement leurs préférences. Par exemple, des interrupteurs simples pour désactiver certains types de profilage ou supprimer des données spécifiques[3]. Des messages contextuels, comme « Partagez votre historique d’achats pour des recommandations 40 % plus pertinentes », renforcent également la clarté du consentement[3]. Enfin, il est essentiel de définir des objectifs précis pour chaque usage des données et de s'assurer que toute nouvelle utilisation reste conforme au consentement initial[6].

Responsabilité dans les systèmes d'IA

La responsabilité exige que les organisations assument pleinement leurs décisions algorithmiques et corrigent rapidement toute dérive. Cela passe par une gouvernance interne rigoureuse, incluant la création de comités éthiques et des audits réguliers des systèmes d'IA, afin d'assurer transparence et conformité dans toutes les opérations.

Risques de la personnalisation par IA non éthique

Une personnalisation inadéquate via l'IA peut entraîner des conséquences graves pour les entreprises et leurs clients. À titre d'exemple, les amendes liées au RGPD ont atteint un total impressionnant de 5,88 milliards d'euros en 2025, avec une part croissante attribuée aux violations impliquant l'IA [1]. Malgré cela, seulement 37 % des consommateurs déclarent faire confiance aux entreprises pour la gestion de leurs données personnelles [1]. Passons en revue les dérives spécifiques que cette technologie peut engendrer.

Bulles de filtres et manipulation algorithmique

Une personnalisation mal pensée peut enfermer les utilisateurs dans des « bulles de filtres », limitant leur accès à une variété de contenus et produits. Ce phénomène crée un effet de chambre d'écho, réduisant la satisfaction des utilisateurs et freinant leur découverte de nouveaux articles. Par ailleurs, certaines IA exploitent des vulnérabilités psychologiques en recourant à des tactiques comme le défilement continu ou des signaux de rareté artificiels [1].

Un exemple frappant est la discrimination tarifaire dynamique.

"J'ai assisté à des réunions où les équipes juridiques étaient horrifiées d'apprendre que l'outil IA du service marketing modifiait les prix en fonction de la richesse supposée des utilisateurs, déduite de leur historique de navigation. C'est le genre de bombe à retardement en matière de conformité que l'IA a plantée dans des milliers d'organisations." – Ansari Alfaiz, Directeur Marketing Digital et Expert en Conformité RGPD [3]

Cette pratique peut être considérée comme une prise de décision automatisée discriminatoire au sens de l'article 22 du RGPD. En octobre 2025, Meta a fait polémique en utilisant les discussions de ses chatbots IA pour cibler des publicités. Par exemple, un utilisateur mentionnant des spots de randonnée voyait immédiatement des publicités pour des chaussures de randonnée sur Instagram [3].

Vulnérabilités en matière de sécurité des données

Au-delà des bulles de filtres, ces pratiques soulèvent également des préoccupations majeures en matière de sécurité. Les systèmes d'IA peuvent déduire des informations sensibles (comme l'état de santé ou le niveau de revenus) sans que ces données soient explicitement fournies, ce qui constitue une atteinte à la vie privée. De plus, des techniques avancées permettent de réidentifier des individus à partir de données anonymisées, rendant inefficaces les méthodes d'anonymisation classiques. En 2025, Clearview AI a écopé d'une amende de 30,5 millions d'euros pour des violations liées à la reconnaissance faciale et à des protections insuffisantes [1].

"Si votre stratégie de personnalisation est mal gérée ou fragmentée, les coûts pour la corriger seront élevés – à la fois en termes d'investissements directs et des dégâts causés à votre réputation par des données non sécurisées ou un marketing intrusif." – Megan Yu, Responsable Produit Interaction Studio, Salesforce [2]

Résultats discriminatoires issus de données biaisées

Les IA s'appuient souvent sur des données historiques qui peuvent refléter des biais existants, entraînant des expériences différentes – et parfois inférieures – pour certains groupes démographiques [1]. Par exemple, cibler uniquement les personnes âgées pour des produits anti-âge renforce les stéréotypes et peut aliéner d'autres groupes de consommateurs potentiels [2]. Ces pratiques peuvent nuire durablement à la réputation de la marque. En vertu de l'AI Act européen, les infractions liées aux systèmes d'IA à haut risque peuvent entraîner des amendes allant jusqu'à 35 millions d'euros ou 7 % du chiffre d'affaires mondial [1]. En avril 2025, la Commission européenne a jugé que l'offre d'abonnement « sans publicité » de Meta ne respectait pas les exigences du RGPD, car elle obligeait les utilisateurs à renoncer à leurs droits à la vie privée [3].

| Tactique de personnalisation IA | Niveau de risque | Principal risque de conformité |

|---|---|---|

| Ciblage comportemental prédictif | ÉLEVÉ | RGPD Art. 22, Absence de consentement |

| Adaptation tarifaire en temps réel | CRITIQUE | RGPD Art. 22, Discrimination |

| Analyse de sentiment par chatbot | ÉLEVÉ | Absence de consentement pour le profilage |

| Personnalisation par cohortes | FAIBLE | Données minimales, généralement sûr |

Ces exemples mettent en lumière l'importance d'adopter des pratiques responsables en matière d'IA, non seulement pour protéger les individus, mais aussi pour préserver la réputation des entreprises.

Comment mettre en œuvre une personnalisation par IA éthique

Une fois les risques identifiés, il est temps de passer à l'étape pratique. Assurer une personnalisation éthique avec l'IA repose sur trois axes majeurs : auditer les données, établir des directives internes claires et maintenir un contrôle continu des systèmes. Ces mesures ne se limitent pas à la conformité réglementaire ; elles renforcent aussi la confiance des clients en garantissant une transparence totale sur l'utilisation des données. Voici comment mettre en place ces pratiques essentielles.

Audit des données d'entraînement pour garantir l'équité

L'audit des données est une étape cruciale. La performance de votre IA est directement liée à la qualité et à la représentativité des données utilisées pour son entraînement. Assurez-vous que ces données reflètent la diversité de vos utilisateurs. Cela implique d’examiner vos jeux de données pour repérer et corriger tout biais éventuel [1]. Avant de commencer l'entraînement, appliquez des techniques de prétraitement et d'anonymisation pour limiter les biais [1]. Adoptez également une approche de minimisation des données : collectez uniquement ce qui est nécessaire, ce qui réduit les risques et simplifie la conformité au RGPD [8].

Établissement de directives éthiques internes

Pour garantir une personnalisation éthique, une gouvernance interne solide est indispensable. Cela commence par la création d’un comité éthique regroupant des experts techniques et juridiques [[8]](https://www.seejph.com/index.php/seejph/article/download/3984/261

Yohann B.